DESCARGA EL PDF castellano DESCARREGA EL PDF català DESCARGA O PDF galego

Autor: David Ríos

Aplicaciones interactivas: Daniel Ramos

Locuciones: César Goldi (voz); Juanjo Fernández (Grabación y efectos sonoros)

CONTENIDO

En los últimos años hemos sido testigos del rápido crecimiento en la capacidad de las organizaciones para explotar los avances en las tecnologías de la información, de la investigación operativa y de la modelización estadística, para recopilar y procesar datos sociales y de mercado, de sensores y de operaciones y así apoyar sus procesos de toma de decisiones.

La captura de datos a través de aplicaciones online y móviles produce cantidades ingentes de información potencial que podemos aprehender para entender cómo actuamos, nos sentimos, nos movemos e interactuamos y cómo respondemos frente a las políticas de los gobiernos y las decisiones de las empresas. En consecuencia, podemos aprovechar los datos para personalizar servicios y productos y automatizar todo tipo de procesos. La irrupción del big data está implicando que, cada vez más, la información proporcionada por los datos constituya la base del análisis y las decisiones, posibilitando procesos más objetivos y automáticos, con las luces y sombras que ello supone.

Luces. Algunos grandes éxitos

Buena parte del interés reciente por el big data y la inteligencia artificial se debe a los éxitos alcanzados en numerosos campos frente a tareas muy complejas que ahora se han convertido casi en una commodity. Un buen ejemplo es la traducción automática, complicadísima hasta hace poco, pero ya con excelentes resultados casi alcanzando el nivel humano. En algunos campos como el márketing personalizado, los sistemas de ventas son capaces de identificar nuestras necesidades incluso antes de que nosotros lo sepamos, como en el famoso ejemplo de Target y la adolescente embarazada. También están posibilitando la emergencia de tecnologías disruptivas como los vehículos autónomos que cambiarán el mundo tal y como hoy lo conocemos. En nuestro país, un proyecto de la Agencia Estatal de Seguridad Aérea ha redefinido cómo se gestionan los riesgos en aviación a nivel estatal, obteniendo enormes ahorros de costes equivalentes de seguridad.

En la base de estos éxitos

Un pilar esencial en estos desarrollos ha sido el acceso a fuentes de datos masivos (Big Data) anotados (por ejemplo, imágenes que vienen anotadas con su contenido).

Muchos de esos datos tenían naturaleza diferente a la habitualmente tratada en la Estadística e Informática; no eran estructurados; contenían imágenes y texto; eran de dimensiones no tratadas hasta ahora…

Todo esto motivó desarrollos matemáticos nuevos en áreas como el procesamiento del lenguaje natural, el procesamiento de imágenes, la optimización, la inferencia causal o la simulación e inferencia bayesiana. Además, se pudo aprovechar las nuevas capacidades de procesamiento de hardware como GPUs y TPUs. Finalmente, se han venido publicando de forma abierta modelos pre-entrenados por expertos que se han podido trasladar a nuevos dominios de aplicación.

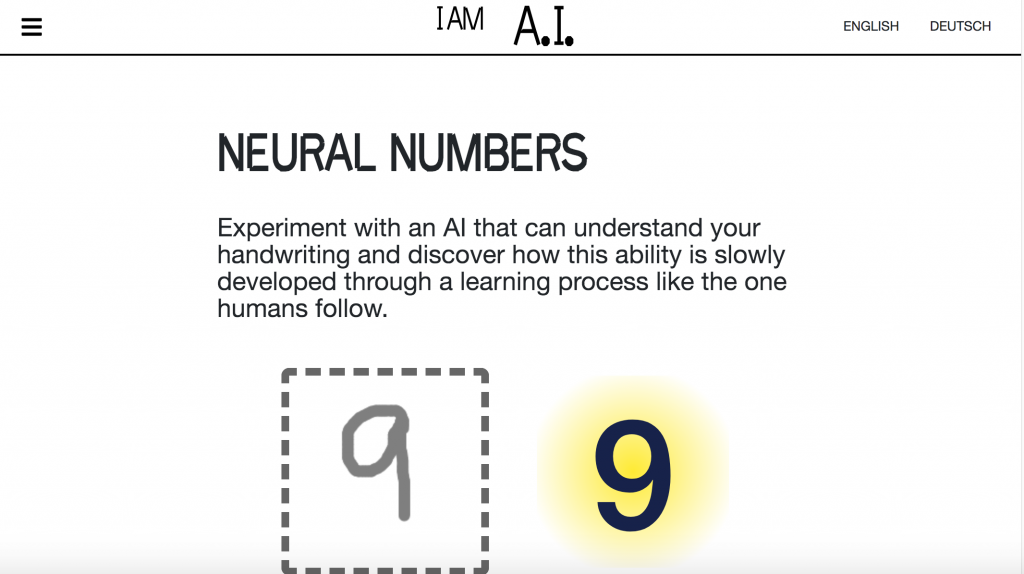

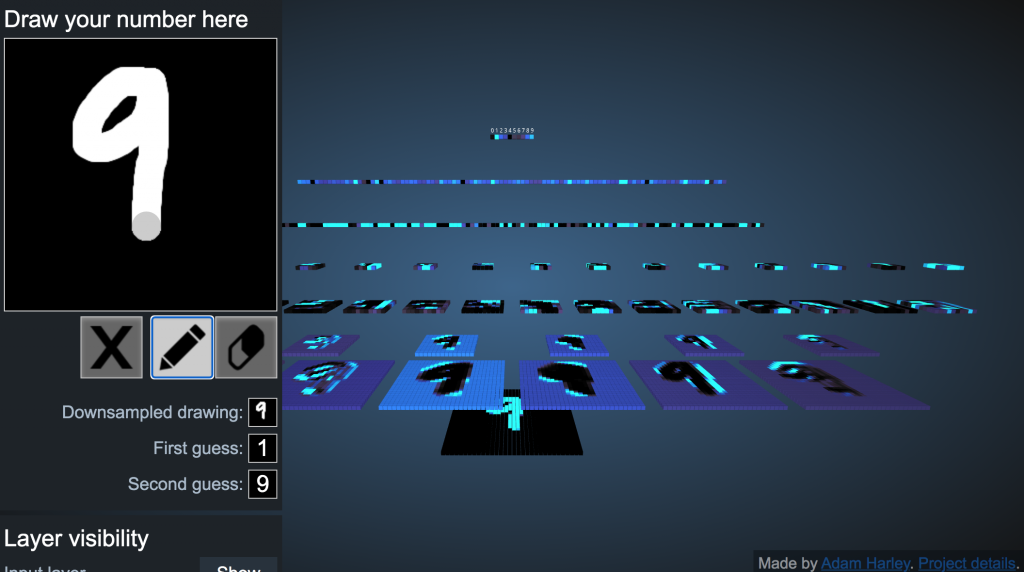

Reconocimiento de escritura manual. Neural Numbers

Se experimenta con una IA (red neuronal convolutiva) que puede entender la escritura manual y se descubre cómo esta capacidad se aprende poco a poco con una estrategia similar a la de las personas

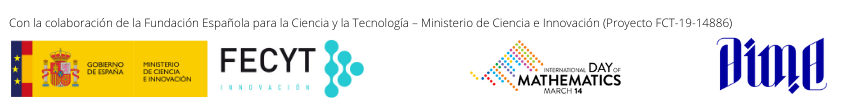

¡¡¡Big Data!!! ¿Qué Big Data?

Aunque es esencialmente un afortunadísimo nombre marketiniano, algo abusado y quizá ya algo desgastado, permite resumir las nuevas categorías de datos a las que nos tenemos que enfrentar.

Volumen: Conjuntos de datos de muy alta dimensión, con muchos individuos y/o con muchas variables.

Variedad: Conjuntos de datos muy diversos, muchas veces desestructurados, con textos, imágenes, likes, videos e incluso ¡números!

Velocidad: Conjuntos de datos generados a muy alta velocidad, que exigen procesamiento también a gran velocidad para apoyar decisiones muy rápidamente.

Valor: Conjuntos de datos de los que, al final del día, hemos de obtener valor.

Para ellos, las herramientas matemáticas, estadísticas y computacionales tradicionales resultaban insuficientes requiriendo nuevos desarrollos.

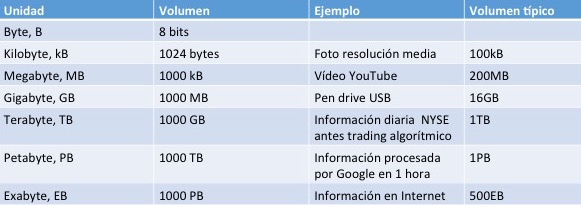

Ciencia de datos

Y en este tsunami científico-técnico, surge la ciencia de datos para unificar la estadística, el análisis de datos, la investigación operativa, el aprendizaje automático y sus métodos relacionados, a efectos de comprender y analizar fenómenos reales, en una intersección que emplea técnicas y teorías extraídas de las matemáticas, la estadística (clásica y bayesiana), las ciencias de la computación, así como los conocimientos propios del problema que queremos resolver.

Recordemos, en cualquier caso, que su fin último es facilitar la toma de decisiones en problemas de interés.

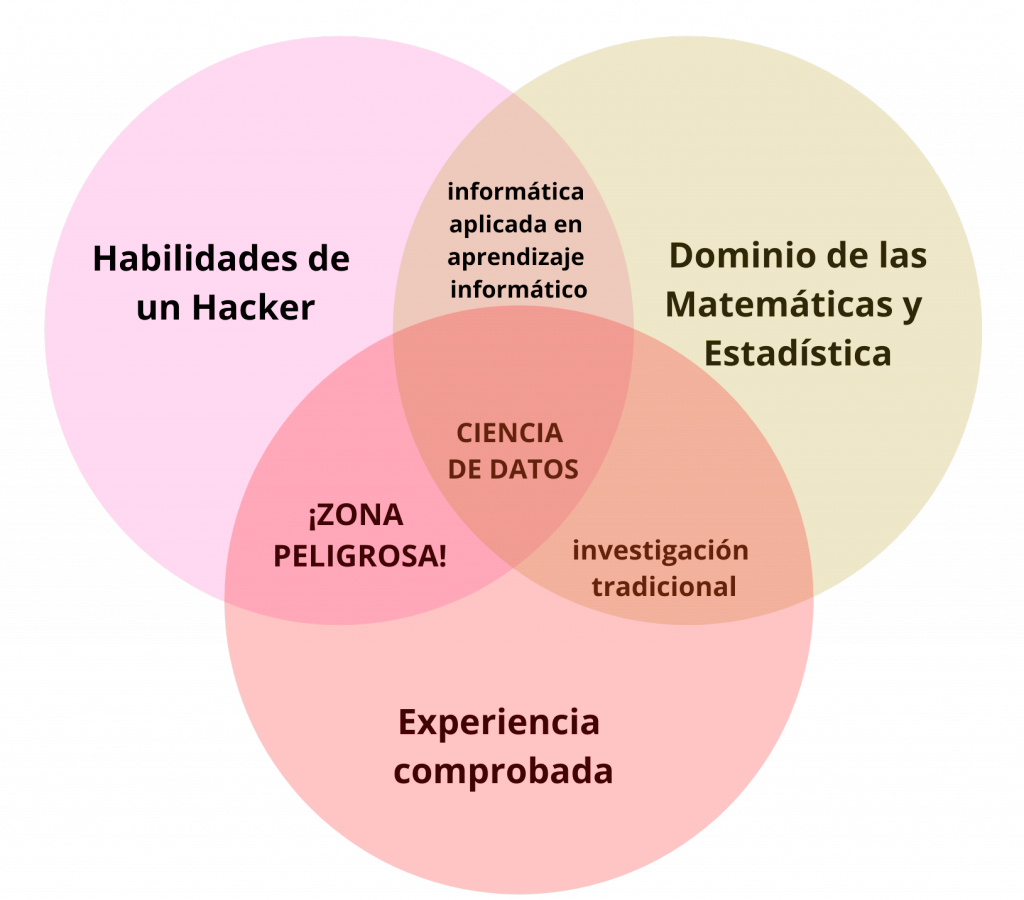

Inteligencia ¿Artificial?

La inteligencia artificial (IA) puede definirse como la capacidad de un sistema para interpretar correctamente datos externos, aprender de dichos datos y emplear tales conocimientos para lograr tareas y metas concretas a través de la adaptación flexible.

Tras su acuñamiento en 1956 y varios vaivenes intelectuales, nos encontramos en una nueva época de esplendor quizá ya definitiva, de esta disciplina. No toda la IA es aprendizaje automático. Ni todo el aprendizaje automático es aprendizaje profundo. Pero éste es el grupo de métodos que, en su capacidad de tratar datos masivos con éxito en tareas de aprendizaje supervisado (regresión, clasificación), aprendizaje no supervisado (conglomerados, estimación de densidades, detección de atípicos, …) y aprendizaje por refuerzo, ha puesto en su lugar central actual a la IA.

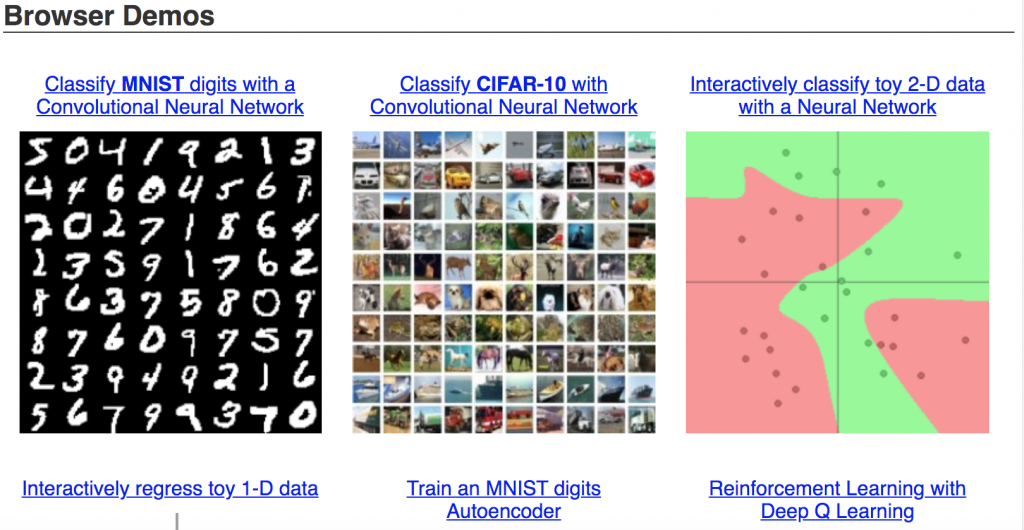

De las redes neuronales a las redes profundas

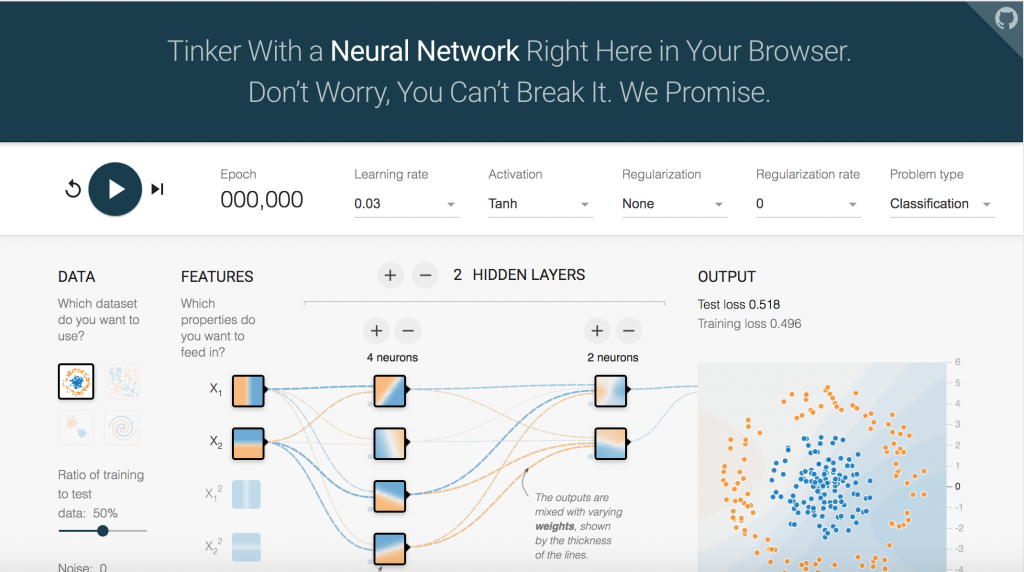

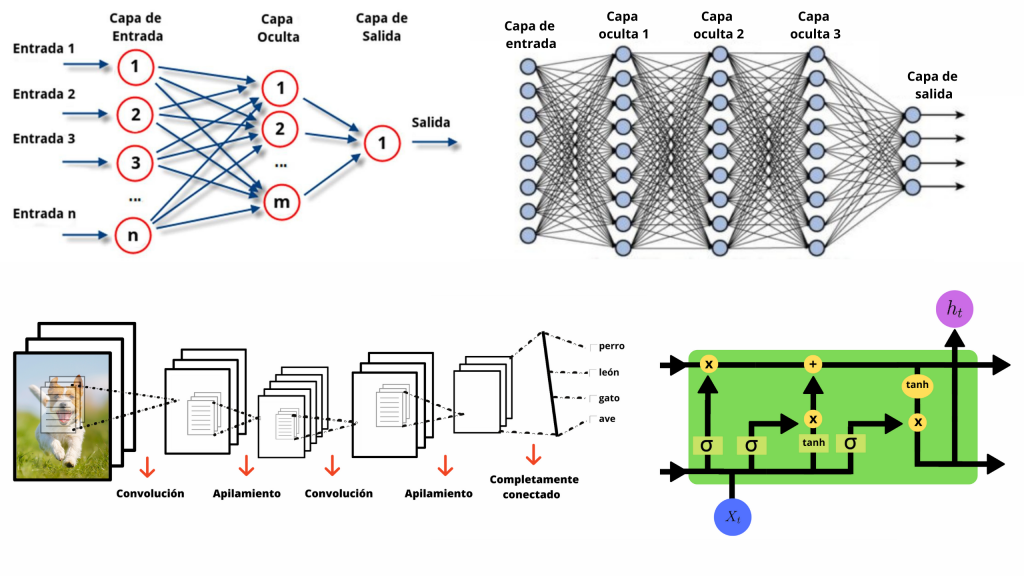

Las redes neuronales son modelos que también han sufrido vaivenes en la historia de la IA y las Matemáticas hasta su relevancia actual. Motivados por un, a veces exagerado, paralelismo biológico, una red neuronal se interpreta como un conjunto de neuronas o unidades que reciben entradas, las combinan linealmente y las transforman mediante una función de activación. De sus combinaciones obtenemos distintas formas o arquitecturas.

En la anterior oleada de moda de la IA, se usaban los perceptrones con una capa oculta: los datos se ingresaban por una capa de entrada a una capa oculta de neuronas que procesaban tales datos para predecir las salidas en problemas de regresión, clasificación y predicción.

En la actualidad, se habla de redes profundas cuando hay varias capas ocultas. Algunos avances técnicos (y el redescubrimiento del algoritmo del descenso del gradiente estocástico de Robbins y Munro) han posibilitado su uso en el tratamiento de problemas complejos. Entre estas nuevas redes profundas están las redes convolutivas, con algunos operadores especiales, que están, por ejemplo, detrás de los grandes avances en procesamiento de imágenes subyacentes a los sistemas de percepción esenciales en los vehículos autónomos.

Juega con un modelo de red neuronal para que entiendas su funcionamiento básico creado por Daniel Smilkov y Shan Carter.

Pero también con sombras…

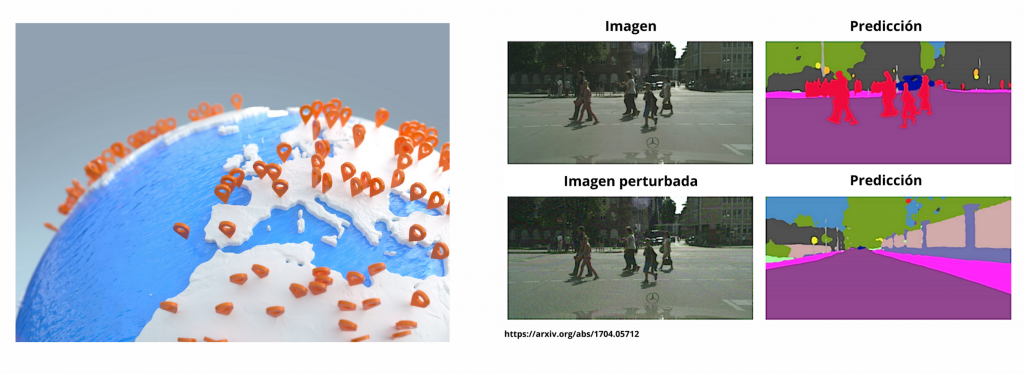

Además de sus éxitos, debemos ser también conscientes de los riesgos asociados a las tecnologías y metodologías de la IA y el Big Data. Uno de ellos son las posibles violaciones a la privacidad. Por ejemplo, a través de la geolocalización basada en la huella que dejamos con algunas apps de nuestro móvil es relativamente sencillo determinar con alta probabilidad donde vivimos y trabajamos o nuestra religión, si es que practicamos alguna.

A través de nuestros textos en twitter, se pueden deducir rasgos de nuestra personalidad a partir de los cuales modular y reformular mensajes (comerciales o políticos) que nos persuadan de ciertas opciones. Además, muchos de los algoritmos, por ejemplo, los basados en redes profundas, tienen escasa capacidad explicativa, lo que puede motivar dudas éticas sobre su aplicabilidad para facilitar la toma de decisiones, problema que se acentúa si se detectan sesgos en tales decisiones automáticas que discriminan a algún colectivo. En algunos dominios pueden darse verdaderos dilemas morales; por ejemplo, al diseñar un vehículo autónomo, debemos hacerlo para que en una situación de emergencia proteja a sus ocupantes o a personas externas en peligro. Finalmente, aunque cada vez se desplieguen más sistemas basados en IA, estos son vulnerables a ataques maliciosos, lo que introduce riesgos obvios sobre sistemas de filtro de contenidos, sistemas de conducción autónoma o sistemas de defensa basados en IA que deben ser robustos en sus respuestas frente a tales ataques.

A través de nuestros textos en twitter, se pueden deducir rasgos de nuestra personalidad a partir de los cuales modular y reformular mensajes (comerciales o políticos) que nos persuadan de ciertas opciones. Además, muchos de los algoritmos, por ejemplo, los basados en redes profundas, tienen escasa capacidad explicativa, lo que puede motivar dudas éticas sobre su aplicabilidad para facilitar la toma de decisiones, problema que se acentúa si se detectan sesgos en tales decisiones automáticas que discriminan a algún colectivo. En algunos dominios pueden darse verdaderos dilemas morales; por ejemplo, al diseñar un vehículo autónomo, debemos hacerlo para que en una situación de emergencia proteja a sus ocupantes o a personas externas en peligro. Finalmente, aunque cada vez se desplieguen más sistemas basados en IA, estos son vulnerables a ataques maliciosos, lo que introduce riesgos obvios sobre sistemas de filtro de contenidos, sistemas de conducción autónoma o sistemas de defensa basados en IA que deben ser robustos en sus respuestas frente a tales ataques.

Otros enlaces de interés

Diviértete pretendiendo ser un virtuoso del piano con ayuda de la IA. Empleando las teclas de 1 a 8 y los botones coloreados para tocar un piano con sus 88 teclas. Cuanto más pretendes ser un pianista, mejor pianista te hará parecer la IA (una red neuronal codificador-descodificador).

Visualización de red convolucional 3D

Una visualización interactiva de enlace de nodo de redes neuronales convolucionales, complementaría a la de neural numbers.

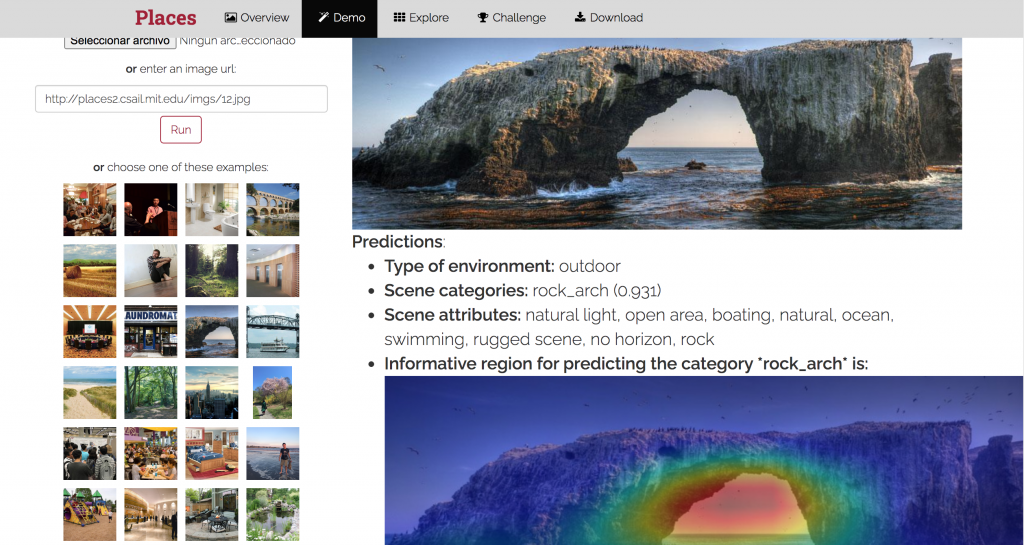

Reconocimiento de elementos de una imagen

Reconocimiento de imágenes siguiendo los principios de la visión humana.

El objetivo es construir un núcleo de conocimiento visual que pueda usarse para entrenar sistemas artificiales para tareas de comprensión visual de alto nivel, como el contexto de la escena, el reconocimiento de objetos, la predicción de acciones y eventos, y la inferencia de la teoría de la mente.

Places: A 10 million Image Database for Scene Recognition. B. Zhou, A. Lapedriza, A. Khosla, A. Oliva, and A. Torralba

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017

Model depot